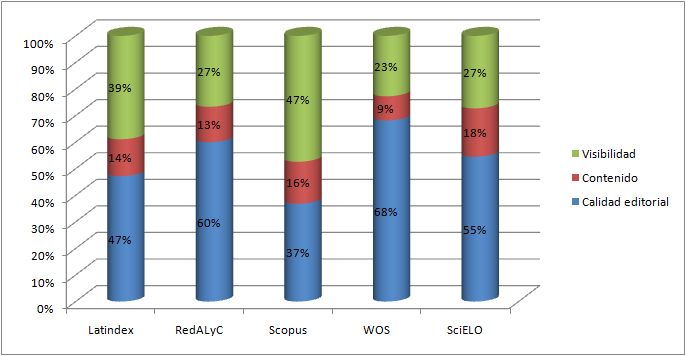

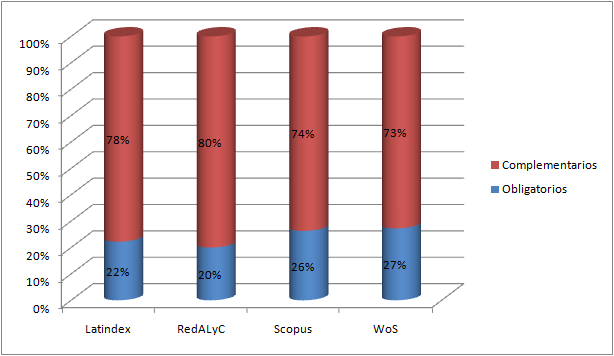

Gráfico 1. Distribución porcentual de los indicadores de cada base de datos por categoría

Artículo/Article

Cecilia Rozemblum1 y 2; Carolina Unzurrunzaga1 y 2; Guillermo Banzato1 y 3 y Cristian Pucacco1

1 Universidad Nacional de La Plata. Facultad de Humanidades y Ciencias de la Educación. Prosecretaría de Gestión editorial y Difusión. 2 Universidad Nacional de La Plata. Facultad de Humanidades y Ciencias de la Educación. Departamento de Bibliotecología. 3 Centro de Historia Argentina y Americana, Instituto de Investigaciones en Humanidades y Ciencias Sociales, Universidad Nacional de La Plata – CONICET. Argentina. E-mail: ceciroz@fahce.unlp.edu.ar

Resumen: Se analizan los parámetros de evaluación utilizados por RedALyC, Catálogo Latindex, SciELO, Scopus y Web of Science para incorporar revistas científicas en sus colecciones, a fin de demostrar su relación con los objetivos perseguidos por cada base y debatir acerca de la valoración que la comunidad científica está otorgándoles a estos sistemas como determinantes de “calidad científica”. Los indicadores utilizados se clasifican en: 1) Calidad editorial (aspectos formales o gestión editorial); 2) Calidad de contenido (revisión por pares u originalidad) y 3) Visibilidad (prestigio de editores y editorial, endogamia, uso e impacto, accesibilidad o indización). Se revela que: a) entre un 9 y un 16% se relacionan con la calidad de contenido; b) falta especificidad en sus definiciones y en la determinación de sus pesos específicos en los sistemas, y c) coinciden con los objetivos de cada base, aunque se observa una marcada tendencia hacia los relacionados con aspectos formales y visibilidad. Se deja así en evidencia que estos sistemas persiguen sus propios objetivos y que conforman núcleo de revistas de “calidad” para su público lector. Se concluye, en consecuencia, que la presencia o ausencia de una revista en estas colecciones, no es parámetro suficiente para determinar la calidad de las revistas científicas ni de sus contenidos.

Palabras clave: Evaluación científica; Revistas científicas; Calidad editorial; Sistemas de evaluación.

Editorial and scientific quality in the parameters for inclusion of journals commercial and open access databases

Abstract: In this article, the parameters used by RedALyC, Catalogo Latindex, SciELO, Scopus and Web of Science for the incorporation of scientific journals in their collections are analyzed with the goal of proving their relation with the objectives of each database in addition of debating the valuation that the scientific society is giving to those systems as decisive of "scientific quality". The used indicators are classified in: 1) Editorial quality (formal aspects or editorial management). 2) Content quality (peer review or originality) and 3) Visibility (prestige of editors and editorial use and impact, accessibility and indexing) It is revealed that: a) between 9 and 16% of the indicators are related to the quality of content; b) Lack specificity in their definition and determination of measure systems, and c) match the goals of each base, although a marked trend towards formal aspects related and visibility is observed. Thus makes it clear that these systems pursuing their own objectives, making a core of journals of “quality” for its readership. We conclude, therefore, that the presence or absence of a journal in these collections is not sufficient to determine the quality of scientific magazine and its contents parameter.

Keywords: Scientific evaluation; Scientific journals; Editorial quality; Evaluation systems.

El incremento de revistas científicas se ha acelerado a la par del crecimiento de la producción científica y sus contenidos son cada vez más especializados. Este tipo de publicación ha sido posicionada por la comunidad científica como medio eficiente y transparente para la evaluación de las comunidades de investigadores (Buela-Casal, 2002) y el artículo científico se ha convertido en una contribución altamente valorada por el “mundo académico”.1 La diversidad de las contribuciones y su relevancia varían en cada disciplina, junto con otros hábitos y prácticas que marcan diferencias y reflejan la naturaleza de la ciencia, como los modelos de autoría, la periodicidad, la extensión, los estilos de citación, la forma de presentación y la estructura lógica (Delgado-Lopez-Cozar y Ruiz-Pérez, 2009). Con el advenimiento de las tecnologías de información y comunicación (TICs), la edición, la publicación y la difusión de las revistas científicas se han visto favorecidas. Actualmente, gran parte de ellas se encuentran disponibles a través de Internet en su propia web y/o mediante alguna base de datos en la que están indizadas (Abadal y Rius, 2006).

La revisión por pares, junto con la exigencia de originalidad, fueron hasta hace algunas décadas los dos elementos considerados por la comunidad científica para certificar, validar y garantizar la calidad de los contenidos de las revistas especializadas (Romanos de Tiratel, 2008). Sin embargo, han surgido otras razones, por ejemplo el interés de los gobiernos por medir la actividad científica para diferentes propósitos (Godin, 2002), o el crecimiento exponencial de la producción científica, que han incentivado a los estudiosos de la ciencia a elaborar sistemas de evaluación de calidad, que se han ido perfeccionando y complejizando (Garduño Oropeza y Zúñiga-Roca, 2011) y que, sirviendo como criterios de selección, intentan definir núcleos de revistas de “calidad” por disciplinas.

En el mismo sentido, el desarrollo de diferentes bases de datos de revistas científicas llevó a la definición de sistemas de evaluación propios, que les permiten constituir sus colecciones, a partir de determinados criterios de “calidad”. Cada uno de estos sistemas de evaluación es diseñado de acuerdo con intereses particulares, razón por la cual la naturaleza (cuanti-cualitativa), el peso específico de cada indicador y el grado de profundidad e importancia varían según los objetivos perseguidos por cada base de datos. Tal como lo subrayan Giménez Toledo y Román Román (2001), el peso específico de cada indicador en el sistema “es un factor determinante a la hora de emitir un juicio global sobre cada una de las revistas y además refleja los aspectos que se pretende potenciar”. Los indicadores, que adquieren diferentes formas y denominaciones según la base de datos, suelen referirse a aspectos similares y están destinados a evaluar distintos aspectos de la revista (Penkova, 2011). Han sido agrupados de diferentes formas por los propios sistemas y por los diferentes autores que los han estudiado. Unos se relacionan con contenido, forma, gestión editorial, uso, impacto y acceso, mientras que otros se encuentran en estrecha relación con el soporte, como los definidos por Abadal y Rius (2006) en torno a su adecuación al medio digital (accesibilidad y usabilidad, ergonomía y conservación). También han sido agrupados de acuerdo con los fines que se propongan, como internacionalidad, calidad y normalización (metadatos / indexación) (Alperin et al., 2011).

Sin embargo, no debemos olvidar que la calidad de los contenidos está dada principalmente por la evaluación cualitativa que realizan los pares de la disciplina con la revisión de cada contribución, generalmente en el sistema doble ciego, una práctica que si bien tiene sus problemas (Link, 1998; Tregenza, 2002), sigue siendo la más extendida y reconocida. En este sentido, como señalan Giménez Toledo et al. (2001), las características técnicas y formales de una revista deben ser consideradas en los sistemas ya que son imprescindibles para favorecer y facilitar la trasferencia de información, pero no deberían resultar determinantes. En la misma línea, Pérez Álvarez-Ossorio (2001) sostiene que la normalización “no mide en absoluto la calidad intrínseca de una revista, sino únicamente lo que podríamos llamar calidad formal” pero que esta es lo primero que requieren las bases de datos, tras el supuesto de que la calidad formal suele ir en paralelo con la intrínseca, siendo la primera pre-requisito para la segunda.

Por otra parte, existe una sobrevaloración en la utilización de los indicadores de impacto y una crítica con respecto a los sesgos de inclusión en las bases de datos, especialmente cuando estos indicadores son utilizados por los sistemas de evaluación científica para calificar las publicaciones de los investigadores (Guédon, 2011). Tal es el caso del discutido factor de impacto que, como marcan Borrego y Urbano (2006), está en ocasiones mal utilizado, ya que se lo equipara a la calidad de la publicación, de sus contenidos y/o de su relevancia. Las discrepancias y discusiones suscitadas en la comunidad científica internacional han llevado a plantear el diseño de métricas alternativas, que midan el impacto más allá de la citación, tales como el uso en línea, las visitas a un documento o los enlaces en las redes sociales (Torres-Salinas et al., 2013; Alperin, 2014). En ese sentido, las críticas al excesivo poder que están asumiendo los sistemas de información en la evaluación de la producción científica fueron claramente expuestas por Renato Ortiz (2009), quien ha realizado un fundamentado análisis de la lógica funcionalista que sustenta los principios de funcionamiento de las bases de datos. Concentrándose en las de Web of Science (WoS), demuestra que, siendo dudosa su utilización en las ciencias en general, en el caso de las Ciencias Sociales es inaplicable. Sin embargo, Ortiz argumenta que los principios cientométricos de las bases de datos se siguen sosteniendo debido a que “dos instituciones garantizan su materialidad: los organismos de evaluación científica y el mundo académico”. El conteo de citas manifiesta “de manera ‘inequívoca’ la relación entre excelencia y reconocimiento”, por lo que estos datos serían utilizados como indicadores de visibilidad y, por lo tanto, “se transforman en capital científico” (Ortiz, 2009: 165-167, 169), en información destacada para compararse con otros, sean estos investigadores, revistas o instituciones.

La presencia o ausencia de una revista en diferentes portales de revistas nacionales, temáticos, multidisciplinares, comerciales o institucionales se ha vuelto una cuestión de Estado: gestores, editores y autores reconocen que la inclusión y la indización en éstos, está sirviendo como criterio de evaluación en los sistemas de investigación de la región.2 Como sostiene Chavarro (2013: 2), estos sistemas “se han convertido en autoridades cognitivas en el sistema de comunicación de la ciencia”. En esta instancia se generan las tensiones entre la “calidad editorial” y la “calidad científica” de una revista. Chavarro (2013: 11) toma de Latindex criterios de calidad editorial y de gestión, y de contenido, como referencia para compararlos con los de RedALyC, SciELO, Scopus y WoS, y concluye que "en términos de calidad editorial las revistas que están en uno y otro sistema de indexación son muy similares".

Debe aclararse, entonces, que en el marco de este trabajo entendemos por “calidad científica” aquella que a través de la evaluación por pares y la exigencia de originalidad de los trabajos publicados es controlada por el colegio invisible; es decir, por grupos de especialistas en una disciplina que evalúan la producción científica y que, además, aportan contribuciones para el crecimiento y sostenimiento de las revistas que difunden los resultados de las investigaciones disciplinares (Gracia Guillén, 2005). Desde esta óptica, consideramos entonces que la “calidad editorial” está constituida por los elementos contextuales de la revista, formales, que explicitan y aseguran las regularidades en la gestión de la revista y por ende no deberían prevalecer, en ninguna instancia de evaluación de las revistas, sobre la “calidad científica”.

En ese sentido, surgen algunos interrogantes en relación con la autoridad y con la competencia que la comunidad científica ha entregado a los sistemas de información en la evaluación de la investigación y de las revistas científicas. El primero y más básico de ellos es: ¿cuáles son los criterios de evaluación para la inclusión e indexación de revistas en estos sistemas? ¿Se orientan al propósito de evaluar la “calidad académica” de cada contribución? En esta instancia, el objetivo de este trabajo es demostrar la relación que existe entre los parámetros de evaluación y los objetivos que persiguen las bases de datos Catálogo Latindex, RedALyC, SciELO, Scopus y WoS, a partir del análisis de los parámetros de evaluación que utilizan para seleccionar las revistas científicas que incorporan en sus colecciones. En primer lugar, destacamos el excesivo requerimiento de aquellos parámetros que sólo identifican aspectos formales de la publicación y lo difuso de algunos indicadores demasiado subjetivos. En segundo lugar, discutimos acerca de la utilización de estos sistemas a la hora de evaluar la “calidad académica” de las revistas, de los artículos y de la producción de los investigadores, como también la utilización equivalente de los conceptos de “calidad editorial” y “calidad científica”.

Se estudiaron los criterios de inclusión y los objetivos que persiguen las siguientes bases de datos: Catálogo Latindex, RedALyC, SciELO, SCOPUS y WoS.3 A partir de un análisis preliminar de los requisitos exigidos por las bases y de otras investigaciones realizadas sobre indicadores de revistas (Alperin et al., 2011; Giménez Toledo et al., 2001; Abadal y Rius, 2006), se diseñó una clasificación propia que permitiese agrupar los criterios de acuerdo con los objetivos propuestos. Se establecieron tres categorías principales: 1) calidad editorial, 2) calidad de contenido y 3) visibilidad, desagregadas en distintos indicadores cualitativos, que se detallan a continuación.

1) Calidad editorial (CE): normalización de las formas y de los procedimientos en la edición para facilitar tanto su localización e identificación como la de las contribuciones que publica la revista, otorgándole mayor credibilidad (Giménez Toledo et al., 2001).

a) Aspectos formales: normalización de la información y de la “estructura” de la revista.

b) Gestión editorial: configuración de un flujo de trabajo estandarizado y transparencia en los procesos de edición de la publicación, explicitando cada etapa, desde el envío del autor hasta la publicación y difusión.

2) Calidad de contenido (CC): medición del aporte que los contenidos científico-académicos de una revista pueden llegar a realizar al campo disciplinar (Rozemblum, 2014)4.

a) Revisión por pares: proceso de evaluación externa de los originales, opinión de expertos.

b) Originalidad: contribución sustantiva al campo académico.

3) Visibilidad (VB): elementos que posibilitan ampliar la difusión, distribución, uso y público lector.

a) Prestigio de editores y editorial: prestigio de la editorial como de sus editores.

b) Endogamia: relaciones institucionales de la revista, expresada en la participación de evaluadores y autores externos, nacionales y, tanto mejor, internacionales.

c) Uso e impacto: utilización de los trabajos tanto por la comunidad científica como por el público en general, incluyendo las medidas de análisis de citas y factor de impacto, uso en línea, descargas y otras métricas alternativas.

d) Accesibilidad: elementos propios del soporte digital que se relacionan con su adecuación al medio y las facilidades de los sistemas para interoperar (Abadal y Rius, 2006), tales como la visualización (formatos), caracteres romanos y acceso a los contenidos, página web amigable, acceso abierto, protocolos OAI.

e) Indización: difusión internacional a través de la incorporación de metadatos traducidos a otros idiomas y la mención de inclusión e indización en bases de datos.

Luego, se analizó cada indicador de los sistemas de evaluación de las bases de datos y se lo clasificó según las categorías propuestas a fin de ponderar el énfasis que cada una pone en la evaluación de las revistas. Cabe resaltar que la utilización de porcentajes para graficar comparativamente las bases de datos no pretende destacar cuales criterios son más importantes para cada una sino solamente su presencia. Adicionalmente, se vinculó la formulación discursiva de los objetivos de las bases de datos para determinar si se reflejaban de alguna manera en la importancia adjudicada a cada grupo de indicadores.

Un primer análisis de los porcentajes de indicadores definidos por cada base de datos en relación con las categorías propuestas (gráfico 1) muestra claramente que:

a) la mayor cantidad de indicadores se concentran en la categoría calidad editorial en todas las bases, excepto Scopus. Se destacan RedALyC y WoS, que superan el 60%;

b) los porcentajes menores corresponden a la categoría calidad de contenido, que en ningún caso supera el 18%;

c) con respecto a los indicadores de visibilidad, Latindex y Scopus son las que más requisitos de esta categoría solicitan, 39% y 47% respectivamente, mientras que el resto no alcanza el 30%.

Gráfico

1. Distribución porcentual de los indicadores de cada base de

datos por categoría

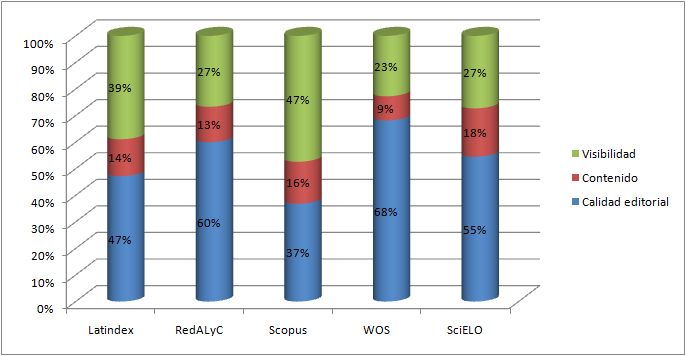

En el gráfico 2 se muestra la distribución porcentual de los indicadores de las cinco bases estudiadas según las subcategorías definidas. En él puede verse que entre los destinados a la gestión (33%) y a los aspectos formales (22%) alcanzan más de la mitad de la distribución, mientras que los de originalidad (7%) y revisión por pares (7%), sumados, sólo llegan al 14%.

Gráfico

2. Distribución porcentual de los indicadores de las cinco bases

por subcategorías

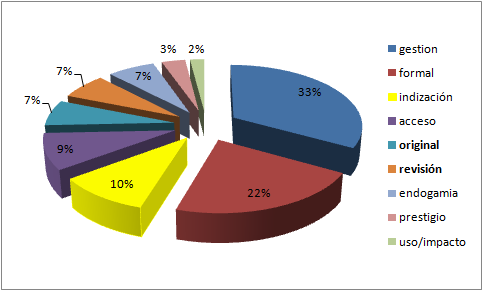

En el gráfico 3 se hace notorio, nuevamente, que en todas las bases de datos los indicadores de gestión y formales son los más requeridos, mientras que los menos solicitados son los de impacto y prestigio. Asimismo, sobresale RedALyC por el alto número de parámetros formales y de gestión que incluye en su sistema de evaluación. Se destaca, por otra parte, la ausencia de parámetros formales requeridos por Scopus, de acceso por SciELO, y de prestigio por WoS y SciELO.

Gráfico

3. Distribución

de indicadores de cada base de datos por subcategorías

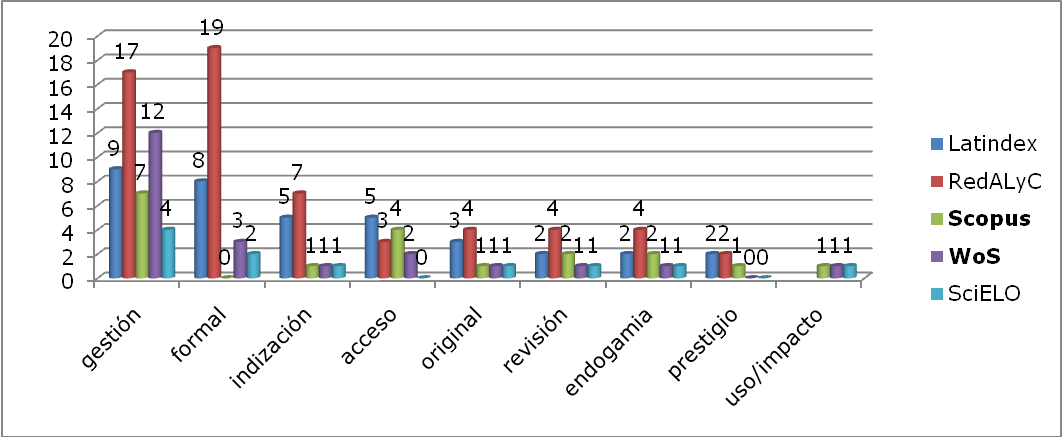

En los gráficos 4, 5, 6 y 7, se muestran, por base de datos, los indicadores obligatorios y complementarios, en cada categoría. No se incluye SciELO porque esta base solicita el cumplimiento del 80% de los indicadores sin especificar cuáles son obligatorios y cuáles complementarios.

|

Gráfico 4. Latindex

|

Gráfico 5. RedALyC

|

|

Gráfico 6. Scopus

|

Gráfico 7. WoS

|

Gráficos

4, 5, 6 y 7. Distribución

de indicadores obligatorios y complementarios por base de datos según

categorías propias

Referencias:

CE (Calidad editorial), CC (Calidad de contenido) y VB (Visibilidad).

En el gráfico 8, se evidencia que, así como lo requiere SciELO, el resto de las bases de datos sitúan alrededor del 80% la cantidad de indicadores complementarios y sólo son un 20-27 % los obligatorios.

Gráfico

8. Distribución

de indicadores obligatorios y complementarios por base de datos

A partir de los objetivos explicitados en cada uno de estos portales, y teniendo en cuenta que los editores de revistas los consultan a la hora de adecuar los formatos y gestionar sus revistas a fin de acceder a estas indexaciones, vamos a considerarlos según lo manifiesta cada uno de los portales, sabiendo que esta relación entre objetivos y requisitos puede ser un tanto lineal. Nuestra hipótesis es que los objetivos comerciales o de difusión enunciados discursivamente por las bases de datos estarían relacionados con las características de los requisitos solicitados para la inclusión e indexación de revistas. Como demostraremos, objetivos y requisitos se concentran en los aspectos de calidad editorial, de gestión y visibilidad en mucha mayor medida que en la calidad de contenidos.

A continuación se detalla el análisis, desde los portales con menor número de requisitos a los de mayor cantidad: SciELO (11), Scopus (19), WoS (22), Catálogo Latindex (36) y RedALyC (60).

SciELO

En concordancia con su objetivo de constituirse como un modelo diferenciado de publicación electrónica, el análisis de los indicadores del sistema de evaluación de SciELO (tabla 1) permite decir que el mayor porcentaje de éstos (55%) se relacionan con la calidad editorial (4 de gestión editorial y 2 aspectos formales). Los demás requisitos solicitados se distribuyen equitativamente entre las demás subcategorías. Hay un indicador diferenciado para cada una de las subcategorías definidas en calidad de contenido: originalidad y revisión por pares; luego, las demás están en la de visibilidad: endogamia, indización e impacto. De este último grupo debe mencionarse que no encontramos los indicadores de prestigio de editores y editorial, uso/impacto y accesibilidad, ausencias que también están relacionadas con el objetivo y el servicio de publicación que ofrece.

Tabla 1. Categorización indicadores de SciELO

|

SciELO |

||||||

|

Calidad editorial |

Contenido |

Visibilidad |

Total |

|||

|

4 |

gestión |

1 |

original |

1 |

endogamia |

|

|

2 |

formal |

1 |

revisión |

1 |

indización |

|

|

|

|

|

|

1 |

impacto |

|

|

6 |

|

2 |

|

3 |

|

11 |

|

55% |

|

18% |

|

27% |

|

100% |

Scopus

En tanto, entre los indicadores declarados por Scopus (tabla 2) pudo notarse que existe una preferencia hacia los relacionados con la categoría visibilidad: alcanza el 47%, y la categoría que sobresale dentro de este grupo es la de acceso (4); luego, se distribuye el resto entre las demás (endogamia 2, indización 1, prestigio 1 e impacto 1). Este peso de su sistema de evaluación puesto en la visibilidad coincide con su objetivo empresarial de convertirse en una herramienta de navegación internacional multidisciplinaria, para lograr una distribución geográfica equitativa de los títulos que contiene. También muestra, al ser de acceso comercial, que se pone énfasis no sólo en satisfacer las necesidades informativas de los usuarios sino también en hacer que el usuario tenga una experiencia satisfactoria.

Tabla 2. Categorización indicadores de Scopus

|

Scopus |

||||||

|

Calidad editorial |

Contenido |

Visibilidad |

Total |

|||

|

7 |

gestión |

1 |

original |

4 |

acceso |

|

|

0 |

formal |

2 |

revisión |

2 |

endogamia |

|

|

|

|

|

|

1 |

indización |

|

|

|

|

|

|

1 |

prestigio |

|

|

|

|

|

|

1 |

impacto |

|

|

7 |

|

3 |

|

9 |

|

19 |

|

37% |

|

16% |

|

47% |

|

100% |

WoS

Al analizar los requisitos de WoS (tabla 3) pudo notarse que el 68%pertenecen a la categoría calidad editorial; dentro de ésta, la mayor cantidad de indicadores (12) se concentran en el aspecto de gestión editorial, mientras que el resto de los parámetros se distribuye uniformemente entre las otras subcategorías. La concentración de los criterios en los aspectos relacionados con la calidad formal están en sincronía con el objetivo de ofrecer un “único acceso a la investigación más fiable, integrada y multidisciplinaria”.

Tabla 3. Categorización indicadores de WoS

|

WoS |

||||||

|

Calidad editorial |

Contenido |

Visibilidad |

Total |

|||

|

12 |

gestión |

1 |

original |

2 |

acceso |

|

|

3 |

formal |

1 |

revisión |

1 |

endogamia |

|

|

|

|

|

|

1 |

indización |

|

|

|

|

|

|

1 |

impacto |

|

|

15 |

|

2 |

|

5 |

|

22 |

|

68% |

|

9% |

|

23% |

|

100% |

Catálogo Latindex

A diferencia de los sistemas hasta ahora mencionados, Catálogo Latindex (tabla 4) tiene un claro aumento en la cantidad de requisitos para el ingreso al sistema: 36 indicadores. Entre ellos, los que integran las categorías de calidad editorial y visibilidad completan los porcentajes más altos: 47% y 39% respectivamente. Esta distribución está en conformidad con su objetivo de fortalecer la edición en la región y contribuir a su posicionamiento como canal de la comunicación científica, como también la ausencia de indicadores relacionados con el uso/impacto.

Tabla 4. Categorización indicadores de Latindex

|

Catálogo Latindex |

||||||

|

Calidad editorial |

Contenido |

Visibilidad |

Total |

|||

|

9 |

gestión |

3 |

original |

5 |

acceso |

|

|

8 |

formal |

2 |

revisión |

2 |

endogamia |

|

|

|

|

|

|

5 |

indización |

|

|

|

|

|

|

2 |

prestigio |

|

|

17 |

|

5 |

|

14 |

|

36 |

|

47% |

|

14% |

|

39% |

|

100% |

RedALyC

Finalmente, el sistema de evaluación de RedALyC (tabla 5) es el que más desagrega los indicadores: llega a un total de 60. Resulta paradójico que, si su objetivo es difundir la investigación original e inédita arbitrada, el 60% de los parámetros se refieran a gestión editorial y de aspectos formales, el 27% a los de visibilidad y sólo un 13% esté destinado a indicadores de la categoría calidad de contenido, aunque de los sistemas analizados es el que mayor cantidad destina a esta razón. Dentro de la categoría de visibilidad, el número destinado a indización (7), habla sobre su objetivo de visibilizar la ciencia de la región.

Tabla 5. Categorización indicadores de RedALyC

|

RedALyC |

||||||

|

Calidad editorial |

Contenido |

Visibilidad |

Total |

|||

|

17 |

gestión |

4 |

original |

3 |

acceso |

|

|

19 |

formal |

4 |

revisión |

4 |

endogamia |

|

|

|

|

|

|

7 |

indización |

|

|

|

|

|

|

2 |

prestigio |

|

|

36 |

|

8 |

|

16 |

|

60 |

|

60% |

|

13% |

|

27% |

|

100% |

Debe reconocerse que en los últimos quince años de desarrollo de la edición científica, con el advenimiento de las posibilidades de gestión digital, el aporte de las bases de datos iberoamericanas Latindex, SciELO y RedALyC fue importante para que las revistas de América Latina empezaran a cumplir con criterios básicos de calidad editorial, aunque en buena parte estas revistas reflejaran alta calidad científica. Actualmente, esto ha cambiado dado que ya son muchas las revistas que cumplen los criterios (en gran parte gracias a estas iniciativas) y quizás sea el momento de ir más allá de criterios editoriales, pues estos son necesarios pero no suficientes para evaluar la calidad científica.

Los cinco sistemas estudiados piden entre un 9 y un 16% de parámetros relacionados con el contenido de las revistas científicas -originalidad y revisión por pares-, mientras que el resto, 91/84%, se refieren a calidad editorial y de visibilidad. Puesto que entre los principales objetivos de las bases estudiadas se encuentran el de aumentar la visibilidad de las revistas que incluyen, o el de mejorar su “calidad editorial”, la relación entre objetivos e indicadores estaría totalmente justificada.

Entre los resultados, sobresalen el 47% de parámetros referidos a visibilidad que requiere Scopus tanto como el 60% de indicadores de calidad editorial de RedALyC. Por otra parte, es notoria la ausencia de parámetros formales requeridos por Scopus, de acceso por SciELO, y de prestigio por WoS y SciELO.

Asimismo, en el conjunto de los indicadores, de las cinco bases de datos, el 55% están destinados a la gestión (33%) y a los aspectos formales (22%), mientras que los de originalidad (7%) y revisión por pares (7%), sumados, sólo llegan al 14%. Llama la atención la casi uniformidad en las cinco bases de datos respecto de los porcentajes de indicadores obligatorios y complementarios: un 20 y 80 % respectivamente. Cabría preguntarse cuán importantes son los indicadores complementarios y cuán imprescindibles los obligatorios.

El análisis realizado pone en evidencia que tanto Catálogo Latindex como RedALyC buscan identificar revistas de “calidad” iberoamericanas, lo hacen centrándose básicamente en aspectos relativos a la “calidad editorial” y otorgan en su sistema de evaluación demasiada relevancia a indicadores que poco aportan a la construcción del conocimiento. Esta exigencia podría estar dificultando la visibilidad de revistas con alta “calidad científica” que no cumplen con los aspectos formales. Por otra parte, la sobriedad de SciELO en la cantidad de requerimientos (11) muestra una apertura a la diversidad de idiosincrasias que puede presentar cada revista. Al contrario, el desgranamiento excesivo que propone RedALyC (60 indicadores) obliga a los diferentes editores a ceñirse en una uniformidad que anula las particularidades de cada revista, sin ganar en “calidad científica”, que es el objetivo principal de éstas.

El alto porcentaje de parámetros destinados a medir la calidad formal, en varios de los sistemas, apoya el argumento de que la “calidad editorial” tiene parámetros más cuantificables y concretos, que son más sencillos de cumplir, por lo que resulta más factible poner énfasis sobre éstos, mientras que los parámetros de “calidad científica” quedan sujetos a los evaluadores de las bases de datos y se encuentran menos explicitados. De todas maneras, si el editor cumple los primeros, las bases de datos verán facilitada la tarea de inclusión y sistematización de los contenidos indizados, pero esta “prolijidad” implica cada vez más tareas -y más costos- para el editor de la revista, que debe ampliar su equipo editorial con especialistas de otras áreas o tercerizar tareas, especialmente en el caso de SciELO (Rozemblum et al., 2014).

Además, el estudio llevado a cabo mostró la falta de especificidad de los indicadores utilizados por las bases de datos para la evaluación de las revistas, pues no explican cómo se hacen operacionales esos criterios, como así también, la discrecionalidad de los sistemas de evaluación empleados y de la relevancia que cada indicador tiene dentro del sistema. Por ejemplo, no se especifican cuáles son los elementos que otorgan a una entidad editora más o menos reputación o cuáles son los que vuelven a un artículo más o menos legible. Resulta necesario que las diferentes bases de datos de revistas científicas determinen el peso específico de cada indicador en relación con sus objetivos, lo que permitiría hacer más transparente para los editores los propósitos que persiguen en su evaluación; por ejemplo, visibilidad, accesibilidad, análisis de citación, etc.

Como ha quedado explicitado, los parámetros de evaluación empleados por las bases de datos de revistas científicas tienen directa relación con los objetivos que se propone cada sistema, razón por la cual sería entonces incorrecto utilizar estos criterios con otro fin, como medir la “calidad científica” de las revistas, de sus artículos o de sus autores. Pero no debe perderse de vista que las bases de datos, además de favorecer la visibilidad de la producción científica, se han transformado en la práctica en instancias de evaluación de las revistas. Sea con el argumento de identificar núcleos de “calidad científica” (Scopus) o de “calidad editorial” (Latindex y RedALyC), lo cierto es que la producción científica, que ha tenido ya una revisión por pares, se ve sometida a una nueva evaluación, más centrada en los formatos que en los contenidos.

En conclusión, debe decirse que para medir la “calidad científica” de las revistas, de sus artículos o de sus autores resulta necesario definir otros criterios más allá de que éstas estén o no incluidas en ciertos sistemas de indización basados en evaluación de “calidad editorial”, dado que ningún grupo de estos indicadores puede ser utilizado para evaluar la calidad de un artículo ni mucho menos a su autor en relación con su trayectoria profesional.

Este trabajo intenta aportar al debate que debe comenzar a darse con mayor ímpetu en el ámbito científico, sobre todo en nuestra región, acerca de la influencia que ejercen las bases de datos sobre la gestión de las revistas científicas, al tiempo que se constituyen en organismos supranacionales de evaluación de “calidad editorial”, que está sustituyendo a la “calidad científica” que garantizan los colegios invisibles.

1 Aunque en este trabajo nos ocupamos de los artículos en revistas científicas, debe hacerse aquí la salvedad de que en Ciencias Sociales y Humanas la difusión de los resultados de investigación en formato libro se valora tanto o más que los artículos en revistas científicas (CIECEHCS, 2014).

2 Véase la reciente Resolución 2249/14 de CONICET en: http://www.caicyt-conicet.gov.ar/wp-content/uploads/2014/07/CCSH_-RD-20140625-2249.pdf

3 Criterios

de evaluación disponibles en:

Latindex: http://www.latindex.unam.mx/documentos/docu.html [Citado 16 jul 2014]. Se consideraron los criterios para revistas

electrónicas ya que abarcan los de las impresas y agregan los

propios del soporte digital.

RedALyC: http://www.redalyc.org/info_pe.oa?page=/politica-editorial/metodologiaevalua.html [Citado 16 jul 2014].

SciELO: http://www.scielo.org/php/level.php?lang=es&component=44&item=2 [Citado 15 jul 2014]

SCOPUS: http://www.elsevier.com/online-tools/scopus/content-overview#content-policy-and-selection.

Más

información en: http://www.elsevier.com/online-tools/scopus/content-overview#content-overview [Citado 16 jul 2014]

WoS: http://wokinfo.com/media/pdf/DCI_selection_essay.pdf.

Más información: http://thomsonreuters.com/thomson-reuters-web-of-science/ [Citado 25 nov 2014].

4 Giménez Toledo et al. (2001) agregan bajo esta categoría el comité editorial y la endogamia.

5 El destacado es nuestro.

6 El destacado es nuestro.

7 Semestralmente, asociado a esta base de datos y en acceso abierto, SCImago ofrece indicadores bibliométricos complementarios.

Abadal, E. y Rius, L. 2006. Revistas científicas digitales: características e indicadores. RUSC: revista de universidad y sociedad del conocimiento, vol. 3, nº 1. [Citado 18 oct 2012]. Disponible en World Wide Web: http://www.uoc.edu/rusc/3/1/dt/esp/abadal_rius.pdf

Alperin, J. P. 2014. Altmetr ía podría permitir que el trabajo académico de los países en desarrollo reciba el debido reconocimiento. Disponible en World Wide Web: http://ucrindex.ucr.ac.cr/la-altmetria-podria-permitir-que-el-trabajo-academico-de-los-paises-en-desarrollo-reciba-el-debido-reconocimiento/#more-703

Alperin, J. P.; Fischman, G. E. y Willinsky, J. 2011. Scholarly communication strategies in Latin America's research-intensive universities. Educación Superior y Sociedad, vol. 16, nº 2. Disponible en World Wide Web: http://ess.iesalc.unesco.org.ve/index.php/ess/article/view/409

Buela-Casal, G. 2002. Evaluación de la investigación científica: «El criterio de la mayoría»: El factor de impacto, el factor prestigio y los «diez mandamientos para incrementar las citas». Análisis y modificación de conducta, vol. 28, nº 119, p. 455-476.

Borrego, Á. y Urbano, C. 2006. La evaluación de revistas científicas en Ciencias Sociales y Humanidades. Información, cultura y sociedad [online], nº 14, p. 11-27. [Citado 18 oct 2012]. Disponible en World Wide Web: http://www.scielo.org.ar/scielo.php?script=sci_arttext&pid=S1851-17402006000100002&lng=es&nrm=iso

Comisión Interinstitucional de Elaboración de Criterios de Evaluación para las Humanidades y Ciencias Sociales (CIECEHCS). 2014. Criterios de evaluación de la producción científica de las humanidades y ciencias sociales. Buenos Aires, mimeo.

Chavarro, D. 2013. ¿Son los sistemas de indexación y resumen un indicador de la buena calidad editorial de las revistas académicas? En Actas del IX Congreso Iberoamericano de Indicadores de Ciencia y Tecnología, Bogotá, Colombia, 9 al 11 de octubre de 2013. Disponible en World Wide Web: http://congreso2013.ricyt.org/files/mesas/1dProduccioncientifica/Chavarroponencia.pdf

Delgado-Lopez-Cozar, E. y Ruiz-Pérez, R. 2009. “La comunicación y edición científica: fundamentos conceptuales”. En Homenaje a Isabel de Torres Ramírez: Estudios de documentación dedicados a su memoria. Universidad de Granada, p. 131-150. [Citado 18 oct 2012]. Disponible en World Wide Web: http://ec3.ugr.es/publicaciones/Emilio_Delgado_Lopez_Cozar_y_Rafael_Ruiz_La_comunicacion_y_edicion_cientifica_fundamentos_conceptuales_Granada_2009.pdf

Garduño Oropeza, G. y Zúñiga Roca, M. F. 2011. La comunicación de la ciencia: Génesis e implicaciones contextuales en revistas especializadas. Razón y palabra, nº 77. [Citado 18 oct 2012]. Disponible en World Wide Web: http://www.razonypalabra.org.mx/varia/77%203a%20parte/47_GardunoZuniga_V77.pdf

Giménez Toledo, E. y Román Román, A. 2001. “Elementos de calidad que deben estar presentes en las revistas científicas convencionales y/o electrónicas. Modelos de evaluación”. En Román Román, A., coord. La edición de revistas científicas: Guía de buenos usos. Centro de Información y Documentación Científica CINDOC (CSIC), p. 51-66. [Citado 18 oct 2012]. Disponible en World Wide Web: E-LIS: http://eprints.rclis.org/bitstream/10760/7764/1/GU%C3%8DA.pdf

Giménez Toledo, E.; Gómez Caridad, I. y Vázquez Valero, M. 2001. Normalización. En Román Román, A., coord. La edición de revistas científicas: Guía de buenos usos. Centro de Información y Documentación Científica CINDOC (CSIC), p. 17-34. [Citado 18 oct 2012]. Disponible en World Wide Web: E-LIS: http://eprints.rclis.org/bitstream/10760/7764/1/GU%C3%8DA.pdf

Godin, B. 2002. Outline for a history of science measurement. Science, Technology & Human Values, vol. 27, nº 1, p. 3-27.

Guédon, J.C. 2011. El acceso abierto y la división entre ciencia “principal” y “periférica”. Crítica y Emancipación, vol. III, nº 6, p. 135-182.

Gracia Guillén, D. 2005. De los colegios invisibles al campus virtual. En II Jornada Campus Virtual UCM: cómo integrar investigación y docencia en el CV - UCM. Madrid: Editorial Complutense, p. 12-18. Disponible en World Wide Web: E-LIS: http://eprints.ucm.es/5752

Link, A. M. 1998. US and non-US submissions an analysis of reviewer bias. JAMA, vol. 280, p. 246-247.

Ortiz, R. 2009. La supremacía del inglés en las ciencias sociales. Buenos Aires: Siglo Veintiuno.

Packer, A. L. 2002. El SciELO para nuestras revistas científicas. Interciencia, vol. 27 n°6. [Citado 18 oct 2012]. Disponible en World Wide Web: http://www.interciencia.org/v27_06/editorial.pdf

Penkova, S. 2011. "Criterios nacionales e internacionales de calidad de las revistas científicas en Iberoamérica: Análisis comparativo”. En Cetto, A.M. y Alonso Gamboa, J.O., comps. Calidad e Impacto de la revista Iberoamericana [En línea]. México: Facultad de Ciencias, UNAM, Disponible en World Wide Web: http://www.latindex.unam.mx/librociri/parte_01/01_05/01_05_00.html

Pérez Álvarez-Ossorio, J. R. 2001. L’avaluació de les revistes científiques. BiD: Textos Universitaris de Biblioteconomia i Documentació, nº 6. [Citado 18 oct 2012]. Disponible en World Wide Web: http://www.ub.es/bid/06perez1.htm

Romanos de Tiratel, S. 2008. La revista científica: Panorama internacional, latinoamericano y argentino. Buenos Aires: UBA.

Rozemblum, C. 2014. El problema de la visibilidad en revistas científicas argentinas de Humanidades y Ciencias Sociales: Estudio de casos en Historia y Filosofía. Quilmes: Universidad Nacional de Quilmes. Tesis de maestría. Disponible en World Wide Web: http://www.memoria.fahce.unlp.edu.ar/tesis/te.1031/te.1031.pdf

Rozemblum, C., Bava, L., Unzurrunzaga, C. y Banzato, G. 2014. Costos y beneficios de la inclusión de revistas universitarias en sistemas de información de Acceso Abierto. 12º Jornada sobre la Biblioteca Digital Universitaria, Salta, 6 y 7 de noviembre.

Torres-Salinas, D., Cabezas-Clavijo, Á., y Jiménez-Contreras, E. 2013. Altmetrics: nuevos indicadores para la comunicación científica en la Web 2.0. Comunicar, vol. 21, nº 41. Disponible en World Wide Web: doi: 10.3916/C41-2013-05

Tregenza, T. 2002. Gender bias in the refereeing process? Trends in Ecology & Evolution, nº 17, p. 349-350.

Cita recomendada:

Rozemblum, C; Unzurrunzaga, C.; Banzato, G. y Pucacco, C. 2015. Calidad editorial y calidad científica en los parámetros para inclusión de revistas científicas en bases de datos en Acceso Abierto y comerciales. Palabra Clave (La Plata), vol. 4, n° 2, p. 64-80. Disponible en: http://www.palabraclave.fahce.unlp.edu.ar/article/view/PCv4n2a01.

Recibido: 26 de noviembre de 2014.

Aceptado: 25 de marzo de 2015.

Publicado: 30 de abril de 2015.

Artículo publicado bajo Licencia Creative Commons (CC) AtribuciónNoComercial-CompartirDerivadasIgual 3.0

http://creativecommons.org/licenses/by-nc-sa/3.0/deed.es_AR